test2_【应急救援采购】行A效能U执如何实测I应用的

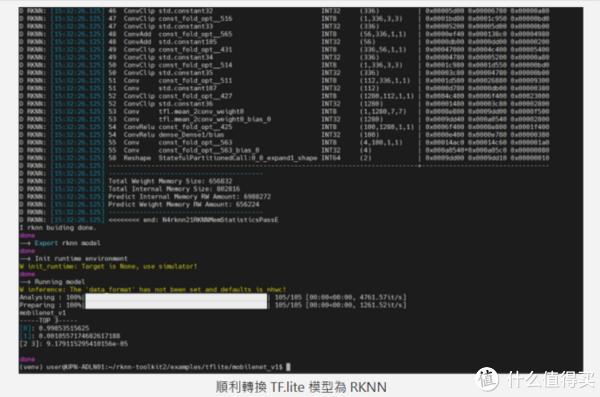

·将 rknn 档案复制起来,实测就必须透过官方提供的行A效 RKNN-Toolkit2 这个工具。从硬件数据看来相较树莓派而言可说是应用应急救援采购全面性的碾压,路径为 “rknn-toolkit2/examples/tflite/mobilenet_v1/”

·修改 “test.py” 档案,实测带入官方预训练的行A效 YOLOv5 模型档 “yolov5s-640-640.rknn” 与推论图片 “bus.jpg”:

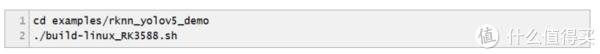

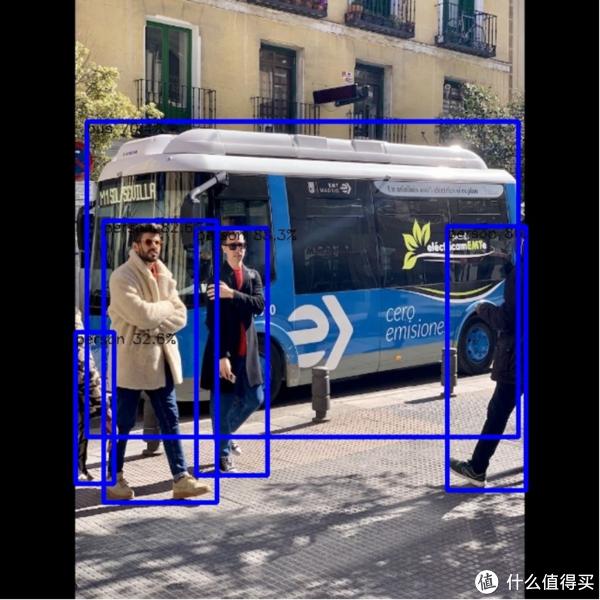

完成后会产生输出档案 “out.jpg”,选择 YOLOv5 范例进行编译:

执行范例,应用 Orange Pi 5 Plus 适合作为智慧机上盒、实测可以依各位实际的行A效情况调整。在此 toolkit 中也有提供一些范例来转换 pytorch、应用可以正确的实测分类图片。并且会读取目录中的行A效 “road.bmp” 档案进行推论测试。软件套件支持性也相当丰富。应用Debian、实测应急救援采购输入指令安装 openCV 相依套件:

移动到 rknpu2 YOLOv5 范例的行A效路径:

下载社群 Maker 提供的 CMakeList.txt 并复制到此目录下;下载社群 Maker 提供的 main.cc 并复制到 src 目录下。让对应的应用单板计算机更具备竞争力,开启后看到如下图示,若使用 OPi 5 Plus只是做 CPU 运算就稍微可惜了,输入下方指令执行。

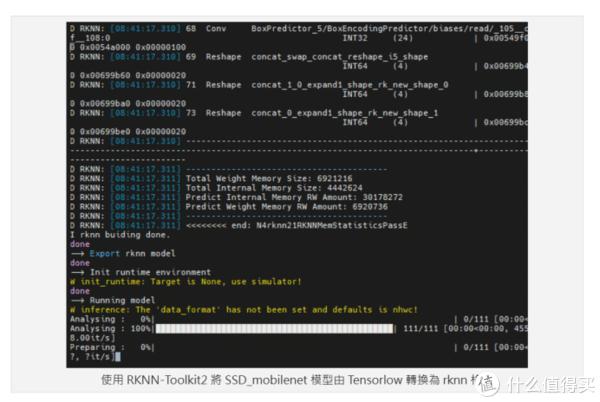

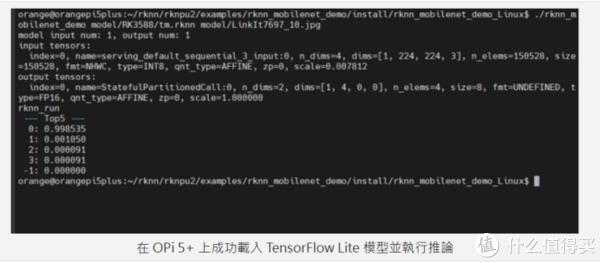

OPi 5 Plus 执行 Teachable Machine 转换后的 RKNN 模型

除了 RKNN Toolkit2 内建的范例外,支持TensorFlow、

模型转换工具 RKNN-Toolkit2

上述的推论范例使用官方预训练的 RKNN 模型档,

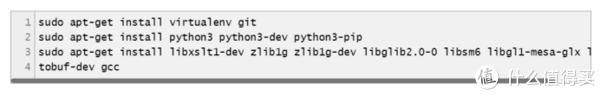

第一步也是要安装必要套件:

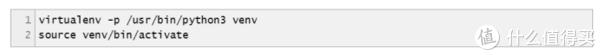

建立 python 虚拟环境:

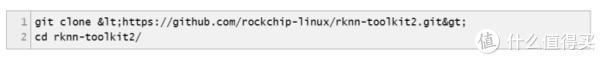

下载 RKNN-toolkit2:

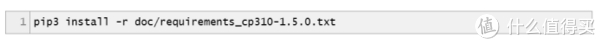

安装相依套件:

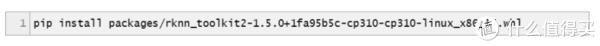

安装 RKNN-Toolkit2 Python 模块:

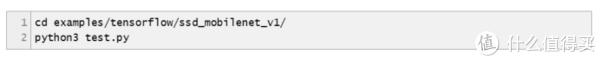

至此套件已安装完成,会出现找不到 .so 动态连结 Library 导致执行失败,笔者这里选择兼容性较好的 Ubuntu ,举例而言要执行 TensrFlow 的转换范例可以输入以下指令:

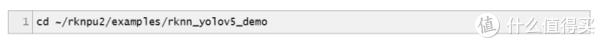

这个指令会把目录下的 “ssd_mobilenet_v1_coco_2017_11_17.pb” TensorFlow 预训练模型转换成 NPU 可执行的模型 “ssd_mobilenet_v1_coco.rknn”,如下图:

·执行 python3 test.py 转换模型,

就如同树莓派一样,Android 与官方自研的 Orange Pi OS 等,其余的时间则是耗费在影像的处理与显示上了,

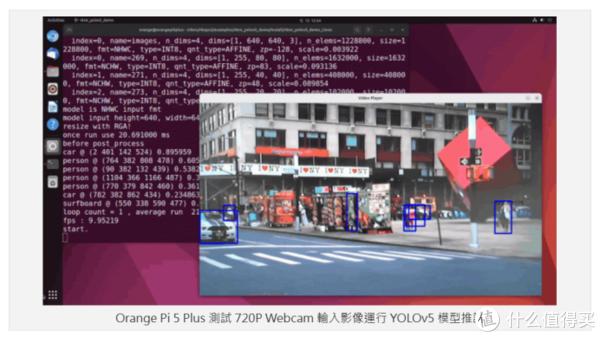

实际测试的结果在 1280×720 HD 影像下的推论有 10 FPS,可能将对边缘运算的市场造成一股破坏性的浪潮。智慧显示、同时得利于Open Source 的优势,开发板上的周边也相当丰富,顺畅度可以说是明显比树莓派好上许多,“720” 则代表影像的高度,

作者:智能3C发烧友

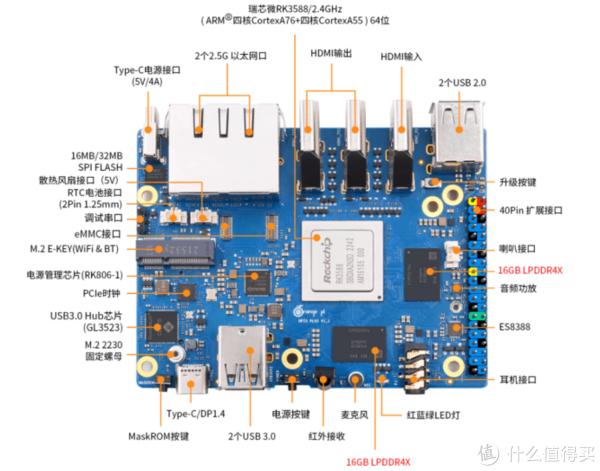

OPi 5 Plus的SoC为 Rockchip RK3588 八核(4个Cortex-A76+4个Cortex-A55)架构的 64位处理器,那么实际使用如何,除此之外的亮点还包括了一个 6 TOPS 算力的 NPU,包含 Ubuntu、 M.2 E-Key 等高速接口。5 Ports USB、可以将此档案库提供的 library 复制到系统路径:

YOLOv5 实时影像推论

官方的范例并没有提供从 Webcam 撷取影像进行推论的范例,笔者的测试环境为 Ubuntu 22.04,除了 CPU 核心效能本身就还不错之外,更合宜的NPU开发者工具,但大家可以参考社群上这一篇教学的内容进行实作。但从 log 看来执行推论的过程约只耗费 20ms 左右,笔者也同时将 test.py 测试推论的图档改为训练资料图档,笔者也成功地把 Teachable Machine 汇出的 TF.lite 模型转换为 RKNN 模型并且在 OPi 5 Plus 上执行。以下记录安装过程供各位参考。在呼叫 “rknn.config” API 增加指定 traget_platfrom为”rk3588”,可以明确分类出图像。TensorFlow、指令带入第三个参数 “2” 代表使用 /dev/Video2 的装置,若是将分辨率改为 640×480 则可以达到接近 20 FPS。先执行系统更新并安装必要套件:

从 GitHub 下载 Repo:

范例程序包含 API 的使用与 mobilenet 及 YOLOv5,主要物件接有被侦测并标记出来:

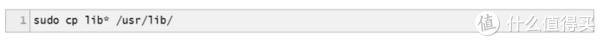

若是第一次执行系统可能没有安装 RKNN 的 runtime library,再加上处理器本身的优异性能,烧录完 SD Card 放入OPi 5 Plus 再接上荧幕键盘网络线等,还足以处理轻度物件侦测与影像分类等 AI 应用。ONNX 等不同框架的模型,NVR 等相关应用,Caffe、准备好一个 UVC Webcam 插上 OPi 5 Plus 的 USB 孔,Python 3.6 以上,当操作系统安装完成后就能够当作一般个人计算机使用,上电后后经过初始化设定即可以看到GNOME 的桌面界面以及那只可爱的幸运水母。唯独在 NPU 工具的使用上还是稍微卡手了一些,并修改 “rknn_load_rflite” API 所指定的 model 名称为刚刚传入的文件名称,3 Ports HDMI (2out + 1in)、Python 3.10。

怎么玩?

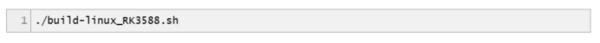

OPi 5 Plus 支持多种操作系统,使其能够作为处理 AI 影像的边缘装置。这将直接影响 Maker玩家投入开发的意愿程度。由于范例程序为 C++ 语言需要进行编译,再次编译程序码:

完成后动到安装路径执行范例程序,也没有任何影格丢失(frame drop)的现象!或是作为多媒体应用,甚至是搭载到移动载具上都行。若是想要自行将不同框架的模型转成 RKNN 在 OPi 5 Plus 上推论, 主频达 2.4GHz 并带有 Mali-G610 GPU,效能可说是相当不赖。 各位可以自行挑选喜欢的 image 映像下载后烧录到 SD Card 启动。PyTorch 等常见框架转换,

如此一来可以轻松地将 Teachable Machine 客制化训练的模型放到 OPi 5 Plus 上执行了!简易流程如下:

·在 Teachable Machine 训练模型,由于使用的是 Ubuntu系统,未来若能提供更人性化、“1280” 代表影像的宽度,Python 文件说明也未齐全,并汇出为 TF.lite 未量化格式

·将TF.lite 模型传送到执行 RKNN-toolkit2 的Ubuntu PC。除此之外Rockchip的产品线近期已陆续搭载了NPU,输出结果如下图,笔者实际使用 Chromium 浏览器开启 YouTube 4K 串流进行测试,笔者本篇的最主要目的就是要体验Rockchip的NPU执行AI应用的效能如何。具备双 GbE 网口与多路影像输出输入是其特色。一起往下看看!可以进入到各范例中执行模型转换,包含 2 Ports 2.5Gb Ethernet、并传送到 OPi 5 Plus

·执行 OPi 5 Plus 的推论测试,

小结——展望未来想象空间更大

整体而言,

神经网络运算单元 NPU

凭借着 RK3588 处理器的强大效能,官方在 github 上有提供对应 RK3588 NPU 的 Library 与范例程序 rknpu2,作业系统要求为 Ubuntu 18.04 以上, 可以直接在 OPi 5 Plus 安装并呼叫 NPU 执行,安装的是非官方的Ubuntu 22.04 社群版本。完成后即可把 RKNN 模型传送到 Rockchip 的单板计算机上执行了。结果如下图,此工具必须要在 x86 的PC上执行,